Logistische Regressionen sind z. B. neben der (multiplen) linearen Regression eine weitere Variante von Regressionsmodellen. Im Gegensatz zur linearen Regression, die bei metrisch skalierten abhängigen Variablen Anwendung findet, nutzt man im Falle einer dichotomen bzw. binären abhängigen Variable eine logistische Regression. Eine solche Variable liegt z. B. vor, wenn sie lediglich zwischen „ja“ (1) und „nein“ (0) oder „vorhanden“ (1) und „nicht vorhanden“ (0) unterscheidet.

Ein konkretes Beispiel ist eine Variable, die eine Stichprobe danach differenziert, ob die Stichprobenelemente an einer Bundestagswahl teilnehmen oder nicht. Die logistische Regression analysiert in diesem Fall Gruppenunterschiede zwischen den Personen, die nicht an der Wahl teilnehmen, und jenen, die ihr Wahlrecht ausüben. Ebenso wie bei der linearen Regression können eine oder mehrere unabhängige Variablen zur Erklärung der Gruppenunterschiede in der abhängigen Variable herangezogen werden.

Analog zur linearen Regression bestimmt auch die logistische Regression Einflussstärken und Einflussrichtungen der unabhängigen Variablen. Da die abhängige Variable jedoch nur zwei Ausprägungen annimmt, wird mithilfe der logistischen Regression kein linearer, sondern ein logistischer Zusammenhang modelliert. Praktisch wird das mit dem nachfolgenden Diagramm deutlicher: Man versucht hier, die Wahrscheinlichkeit der Wahlbeteiligung in Abhängigkeit des Lebensalters (unabhängige Variable) abzuschätzen.

Wie in der Abbildung zu erkennen, zieht eine Veränderung der unabhängigen Variable keine gleichbleibende Veränderung der abhängigen Variable nach sich. Stattdessen geht die Veränderung der unabhängigen Variable bei kleinen und grossen Werten mit einer schwachen Veränderung der abhängigen Variable einher, während sie im Bereich mittlerer Werte stärker ausfallen. Dieser Zusammenhang wird durch die logistische Funktion modelliert.

Nachdem die Voraussetzungen für die Anwendung eines logistischen Regressionsmodells thematisiert wurden, wird nachfolgend ein Anwendungsfall mit SPSS anhand eines Beispieldatensatzes dargestellt. Grundsätzlich bestehen bei SPSS zwei Alternativen, die gewünschten Berechnungen in das Programm einzugeben: via Menüleiste oder über einen Befehlscode, die sogenannte Syntax. Auf eine Eingabe mittels Menü geht der Beitrag ebenso ein wie auf die Eingabe via SPSS-Syntax.

Ist man im Umgang mit dem Programm fortgeschrittener, so lassen sich Arbeitsschritte über diese Syntax effizienter abarbeiten als über manuelle Menüeingaben. Auch bei Seminar- und Abschlussarbeiten wird häufig gefordert, der Arbeit die verwendete Syntax anzuhängen. Sie dient gleichzeitig als von aussen nachvollziehbares Protokoll der Arbeitsschritte.

Die Anwendung einer logistischen Regression setzt bestimmte Bedingungen voraus, wovon die wichtigsten lauten:

- Die abhängige Variable ist dichotom bzw. binär skaliert (genau zwei Ausprägungen 0 und 1). Nominal kodierte Variablen können häufig dichotomisiert werden. Bei metrischen abhängigen Variablen wird jedoch eine lineare Regression verwendet.

- Die unabhängigen Variablen sind metrisch oder als nominal skaliert.

- Keine Multikollinearität (Korrelation innerhalb) der unabhängigen Variablen.

- Datenausreisser sollten nicht berücksichtigt werden, da sie die Ergebnisse des Modells verzerren können.

Logistische Regression in SPSS

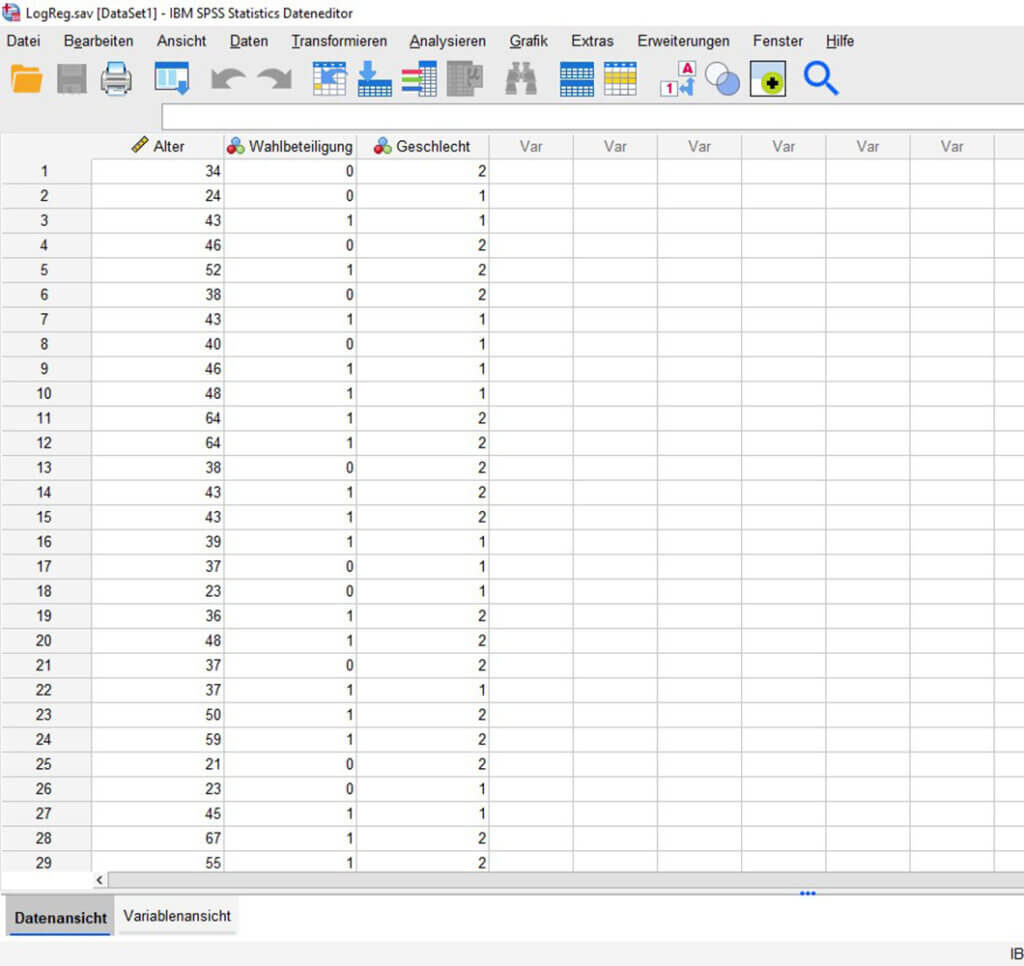

Um eine logistische Regression mit SPSS durchzuführen, wird zunächst der Datensatz geladen. Der fiktive Datensatz enthält Daten von 40 Personen. Es liegen drei Variablen vor: Lebensalter, Wahlbeteiligung und Geschlecht der Befragten. Bei der Geschlechtsvariable handelt es sich um eine kategoriale Variable mit 2 Ausprägungen („männlich“ (1) und „weiblich“ (2)).

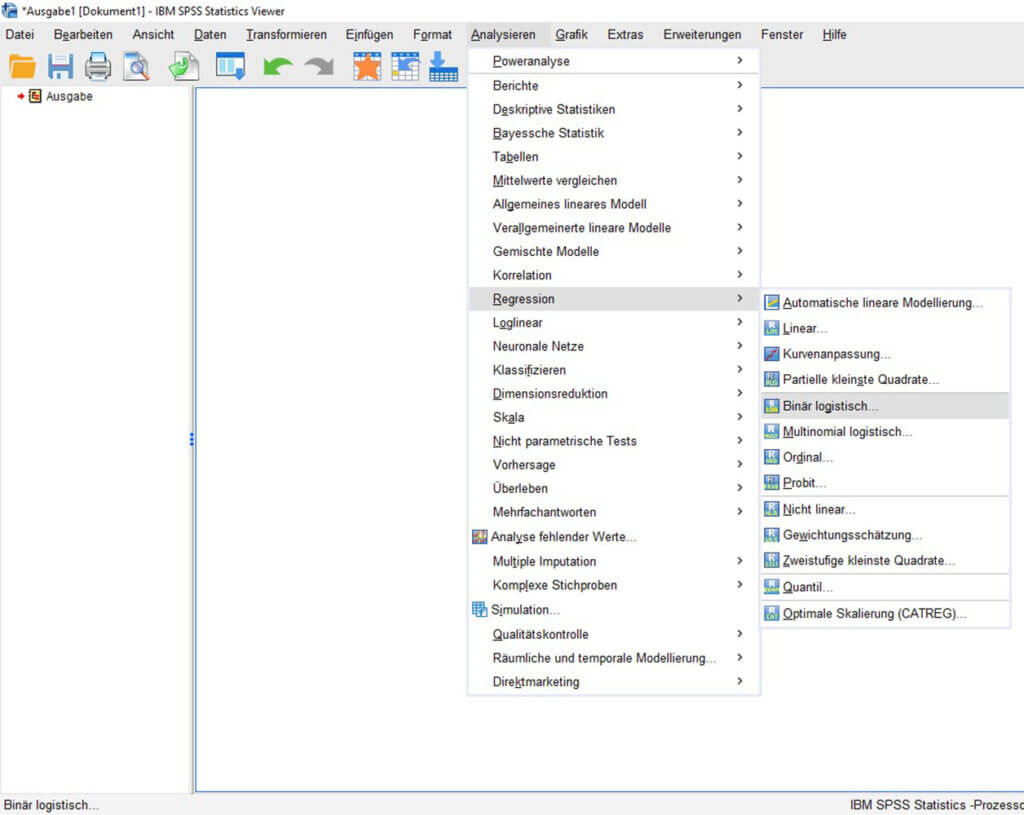

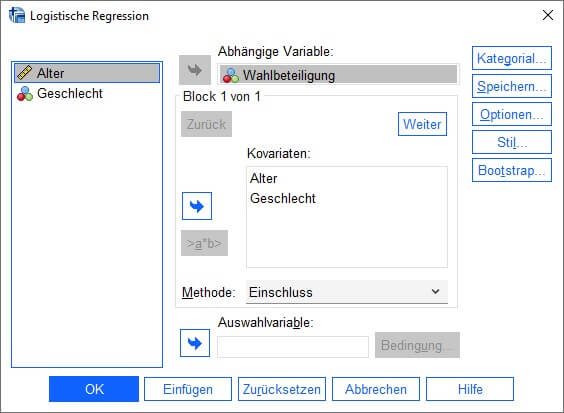

Um über das SPSS-Menü an die logistische Regression zu gelangen, geht man über „Analysieren“, „Regression“ und anschliessend „Binär logistisch“. Schliesslich öffnet sich ein Dialogfeld, das auf der linken Seite die im Datensatz verfügbaren Variablen auflistet. Aus dieser Liste werden nun die Variablen selektiert, die in die Felder „Abhängige Variable“ und „Kovariaten“ (unabhängige Variablen) verschoben werden sollen. Bereits jetzt könnte die Auswahl bestätigt und das Modell berechnet werden.

Das Dialogfeld bietet weitere Anpassungsmöglichkeiten. Eine erste besteht in der Festlegung von Auswahlkriterien unter „Auswahlvariable“. Hier besteht die Möglichkeit, nur definierte Teilstichproben aus dem Datensatz in der Regression zu berücksichtigen, z. B. ausschliesslich männliche Personen oder solche ab einem Alter von 18 Jahren. Für die nachfolgende Regression wird aber auf eine Einschränkung der Stichprobe verzichtet.

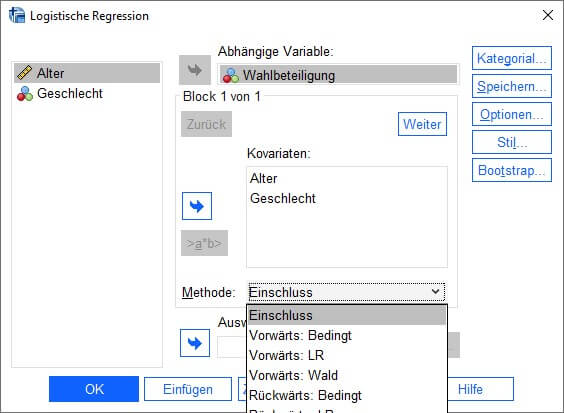

Eine weitere Anpassungsmöglichkeit liegt mit der Drop-down-Liste neben „Methode“ vor. Hier wird festgelegt, auf welche Weise die unabhängigen Variablen in das Modell integriert werden. Die Standardeinstellung „Einschluss“ meint, dass alle Kovariaten zugleich in ein Modell aufgenommen werden. Mit den weiteren aufgeführten Varianten können Variablen entweder schrittweise hinzugefügt oder eliminiert werden. Die Zusatzbezeichnungen „Bedingt“, „Likelihood-Quotient“ und „Wald“ stehen dabei für unterschiedliche Testvoraussetzungen, die für die Aufnahme bzw. Elimination erfüllt sein müssen. In der Regel basiert die Auswahl der unabhängigen Variablen jedoch auf theoretischen Annahmen, die die voreingestellte Methode „Einschluss“ rechtfertigen.

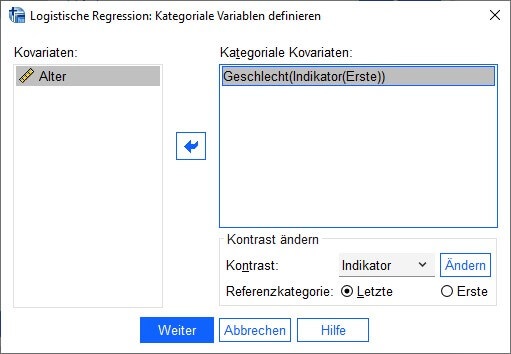

Ebenfalls relevant ist aufgrund der Verwendung der Geschlechtsvariable die Festlegung einer „Referenzkategorie“, die für die Interpretation des Regressionsmodells wichtig wird. So ist der Einfluss einer kategorialen unabhängigen Variable immer in Referenz zu einer fest definierten Variablenausprägung zu interpretieren (s. Interpretation unten). Daher ist die Schaltfläche „Kategorial“ von Interesse, die ohne Beteiligung einer kategorialen Variable vernachlässigt wird.

Nach Anklicken der Schaltfläche „Kategorial“ wählt man die Geschlechtsvariable aus, indem sie ins rechte Feld verschoben wird. Wird als „Kontrast“ nun „Erste“ gewählt, ist die Ausprägung „weiblich“ (2) in Referenz zur ersten Kategorie „männlich“ (1) zu interpretieren. Mithilfe des Drop-down-Menüs „Kontrast“ kann optional eingestellt werden, auf welche Weise die Kategorien miteinander verglichen werden. Die Standardeinstellung „Indikator“ wird hier beibehalten. Die Auswahl wird mit „Ändern“ und anschliessend mit „Weiter“ bestätigt.

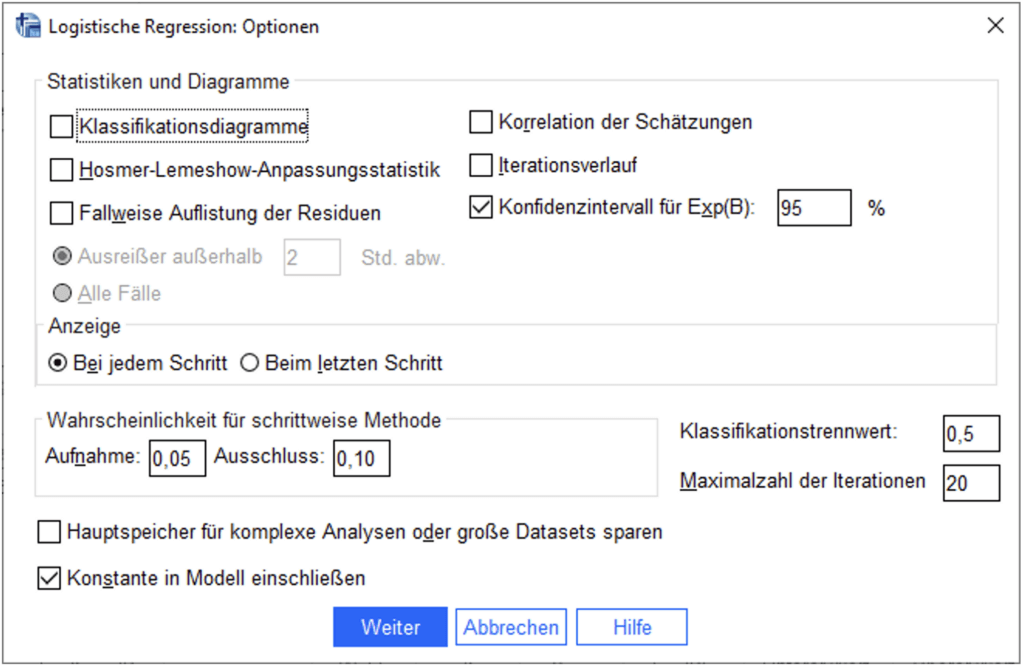

Zuletzt lassen wir uns neben den Regressionskoeffizienten die Odds Ratios der Kovariaten ausgeben, auch als Kennzahl des Chancenverhältnisses bezeichnet. Hintergrund hierfür ist der Umstand, dass auf Basis von Koeffizienten zwar Aussagen über die Richtung von Zusammenhängen abgeleitet werden können, die Effektstärke aber schwieriger zu interpretieren ist. Zusätzliche Odds Ratios ermöglichen dagegen eine zugänglichere Beschreibung des Effekts. Hierfür wird nach Auswahl der Schaltfläche „Optionen“ das Kontrollkästchen neben „Konfidenzintervall für Exp(B)“ aktiviert, das standardmässig mit 95 % definiert ist. Die Einstellung wird mit „Weiter“ bestätigt.

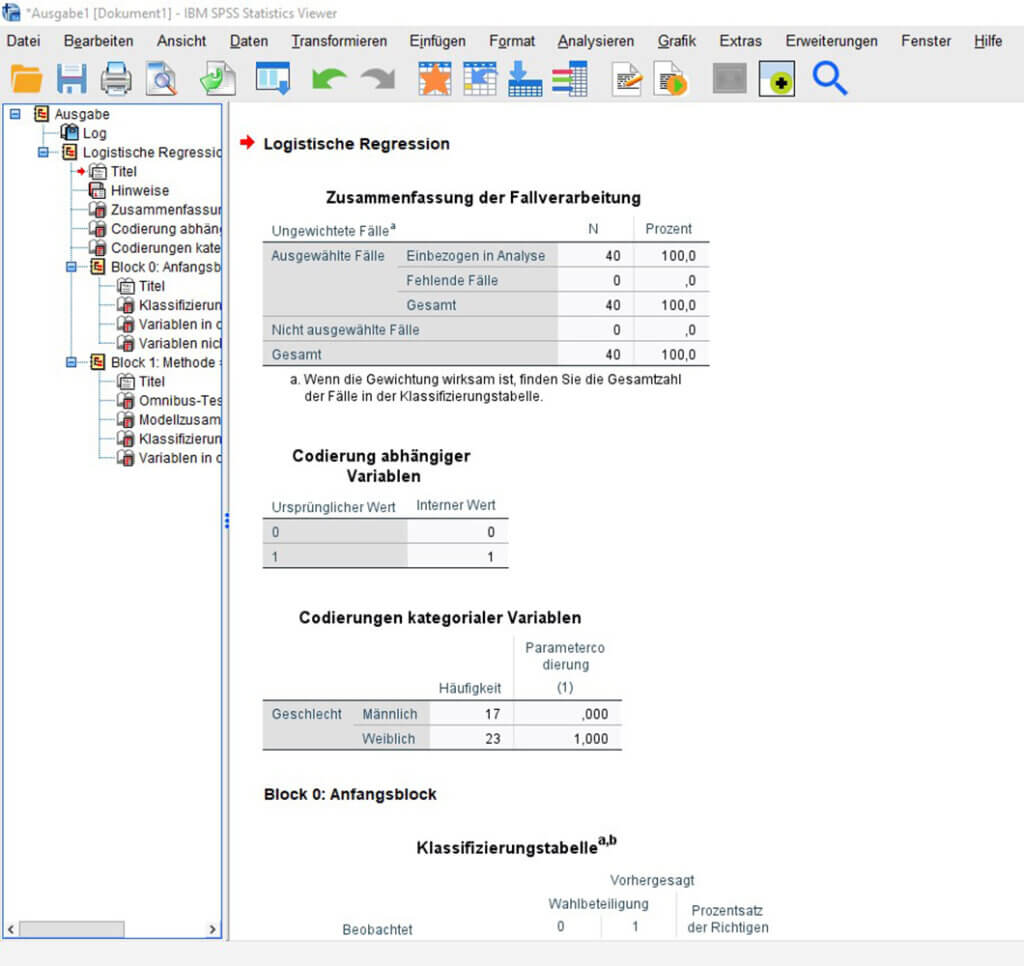

Sind alle Einstellungen innerhalb des Dialogfelds vorgenommen, kann mit „OK“ die gewünschte Ausgabe produziert werden. Relevant sind dabei vor allem die ersten drei Tabellen und die des letzten Blocks, da das Modell hier alle unabhängigen Variablen berücksichtigt. Die erste Tabelle „Zusammenfassung der Fallverarbeitung“ klärt über die berücksichtigten Fälle im Datensatz auf. In diesem Fall konnte der gesamte Datensatz verwendet werden. Die anschliessenden Kodierungstabellen bieten eine Übersicht über die Variablenausprägungen, wobei für die Interpretation in erster Linie die Angaben über die kategoriale Variable relevant sind.

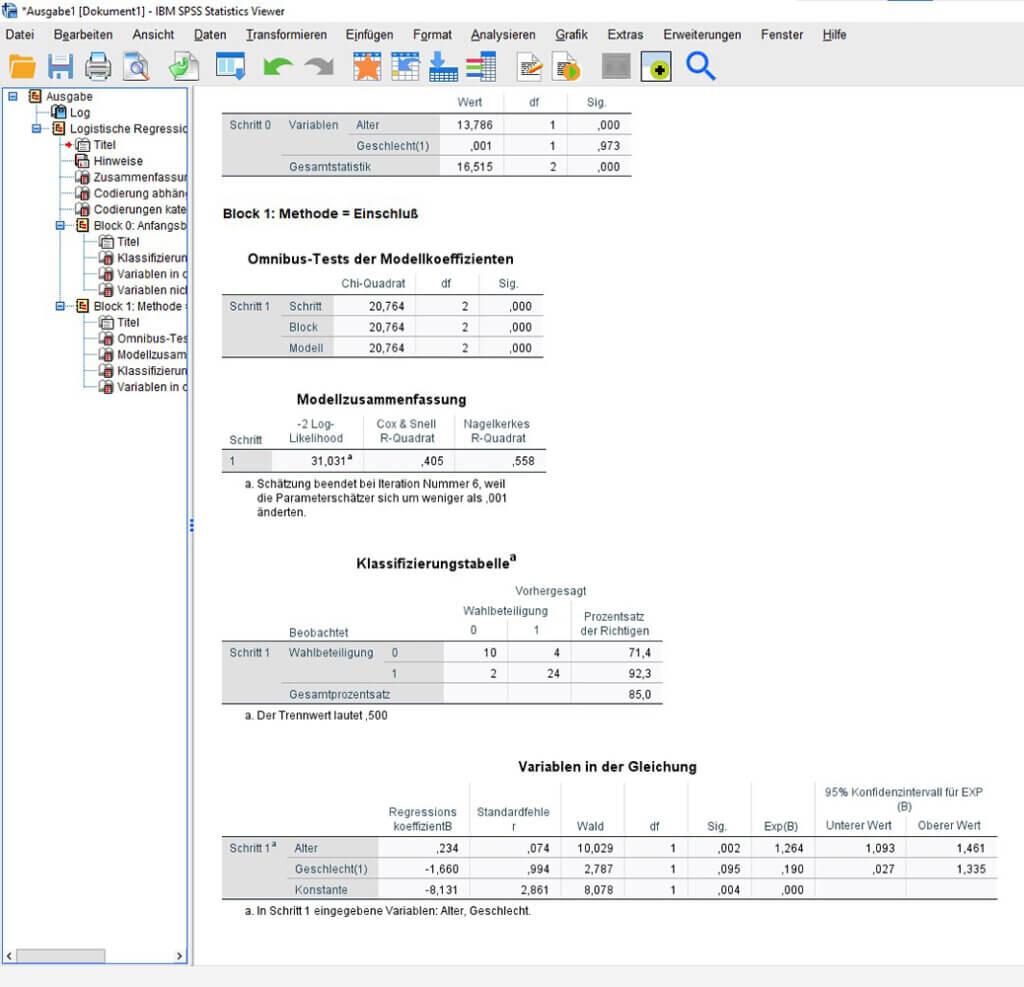

Analog zur linearen Regression wird auch für die logistische Regression eine Modellzusammenfassung produziert. Die Chi-Quadrat-Werte zeigen zunächst an, dass das Gesamtmodell signifikant ist. Die Modellgüte kann anhand der beiden R-Quadrat-Werte beurteilt werden. Die Werte sind zwar nicht, wie im Falle der linearen Regression, als erklärter Varianzanteil zu bezeichnen, haben jedoch eine vergleichbare Aussagekraft.

Die Klassifizierungstabelle gibt an, inwiefern die vorhandene bzw. nicht vorhandene Wahlbeteiligung durch die gewählten Kovariaten vorhergesagt werden konnte. In diesem Fall wurden in 71,4 % der Fälle die Nichtteilnahme und in 92,3 % der Fälle die Teilnahme korrekt vorhergesagt. Es ergibt sich ein Gesamtprozentsatz von 85,0 %, sodass das Modell eine gute Prognosekraft hat.

Im Mittelpunkt des Interesses steht schliesslich die Tabelle „Variablen in der Gleichung“. Für die gewählten unabhängigen Variablen werden u. a. Regressionskoeffizienten, Odds Ratios und Signifikanzwerte ausgegeben. Der Regressionskoeffizient des Alters lässt anhand des positiven Vorzeichens die Aussage zu, dass ein höheres Alter eine erhöhte Wahrscheinlichkeit der Wahlbeteiligung nach sich zieht. Konkreter wird die Interpretation mithilfe des Odds Ratio („Exp(B)“): Ein um ein Jahr erhöhtes Alter erhöht die Wahrscheinlichkeit der Wahlbeteiligung um den Faktor 1,26. Der Effekt ist zudem statistisch signifikant.

Für das Geschlecht wird ein negativer Regressionskoeffizient ausgegeben. Analog dazu ist der Odds Ratio < 1, schliesslich handelt es sich um einen Faktor, der die Wahrscheinlichkeit der Wahlbeteiligung senkt. Konkret kann vor dem Hintergrund der Referenzkategorie geschlussfolgert werden, dass die Wahrscheinlichkeit der Wahlbeteiligung von Frauen (Kategorie 1) im Verhältnis zu Männern (Kategorie 0) um den Faktor 0,19 geringer ist. Es handelt sich allerdings nicht um einen statistisch signifikanten Wert.

Abschliessend wird die Syntax dargestellt, die zum gleichen Ergebnis führt, das über die Menüführung von SPSS generiert wurde. Alle denkbaren Modifikationen der logistischen Regression können auch über diese Befehlszeilen vorgenommen werden.

LOGISTIC REGRESSION VARIABLES Wahlbeteiligung /METHOD=ENTER Alter Geschlecht /CONTRAST (Geschlecht)=Indicator(1) /PRINT=CI(95) /CRITERIA=PIN(0.05) POUT(0.10) ITERATE(20) CUT(0.5).