Info:

Das Journal Ranking wurde nicht von einer einzelnen Person erfunden, sondern entwickelte sich im Laufe der Zeit durch verschiedene Initiativen und Methoden. Der Impact Factor wurde von Eugene Garfield in den 1960er-Jahren entwickelt.

Alternative Metriken und Indikatoren:

Eine umfassendere Bewertung von wissenschaftlichen Zeitschriften

Angesichts der Kritik an traditionellen Journal Rankings wie dem Journal Impact Factor (JIF) haben sich alternative Metriken und Indikatoren entwickelt, die eine differenziertere und umfassendere Bewertung von wissenschaftlichen Zeitschriften und Forschungsergebnissen ermöglichen sollen.

- Altmetrics

Altmetrics sind alternative Metriken, die die Sichtbarkeit und den Einfluss von wissenschaftlichen Publikationen anhand ihrer Online-Aktivitäten messen. Im Gegensatz zu traditionellen Zitationsmetriken berücksichtigen Altmetrics eine breitere Palette von Datenquellen, wie zum Beispiel Downloads, Social-Media-Mentions, Blogposts, Lesezeichen und Empfehlungen in wissenschaftlichen Netzwerken. Altmetrics können dabei helfen, die Verbreitung von Forschungsergebnissen jenseits der wissenschaftlichen Gemeinschaft und die Reaktionen der breiteren Öffentlichkeit auf wissenschaftliche Publikationen zu erfassen.

- Leiden Ranking

Das Leiden Ranking ist ein alternativer Ansatz zur Bewertung von wissenschaftlichen Zeitschriften und basiert auf einer Kombination von Zitations- und Kollaborationsindikatoren. Im Gegensatz zum JIF berücksichtigt das Leiden Ranking auch die Qualität der Zitierungen und die Zusammenarbeit zwischen verschiedenen Institutionen und Ländern. Dadurch soll ein ausgewogeneres Bild von der Bedeutung und dem Einfluss einer Zeitschrift innerhalb der wissenschaftlichen Gemeinschaft entstehen.

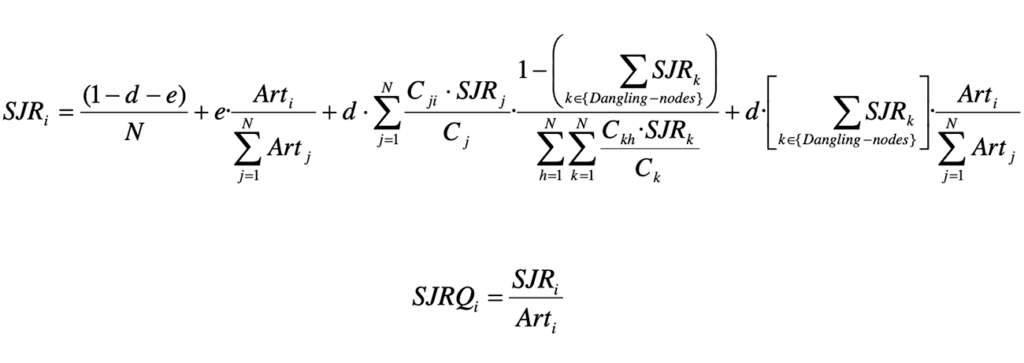

- Eigenfactor

Der Eigenfactor ist eine alternative Metrik, die den Einfluss von wissenschaftlichen Zeitschriften anhand ihrer Zitationsnetzwerke bewertet. Im Gegensatz zum JIF, der nur die durchschnittliche Anzahl der Zitierungen pro Artikel berücksichtigt, misst der Eigenfactor auch die Qualität der Zitierungen und die Bedeutung der zitierenden Zeitschriften. Dadurch soll eine differenziertere und fairere Bewertung der wissenschaftlichen Zeitschriften erreicht werden.

- H-Index

Der H-Index ist eine Metrik, die sowohl die Anzahl der Publikationen von Autor:innen als auch die Anzahl der Zitierungen pro Publikation berücksichtigt. Lesen Sie hier mehr darüber: Hirsch-Index, Scopus-Index und Impact Factor.

Die Verwendung alternativer Metriken und Indikatoren ermöglicht eine umfassendere und differenziertere Bewertung von wissenschaftlichen Zeitschriften. Durch die Berücksichtigung verschiedener Aspekte des wissenschaftlichen Publikationsprozesses können diese Ansätze dazu beitragen, die Qualität und den Einfluss von Forschung umfassender und fairer zu messen und auf die Kritikpunkte und Herausforderungen der traditionellen Journal Rankings zu reagieren.

Interessante Verweise:

- The San Francisco Declaration on Research Assessment (DORA):

https://sfdora.org/

DORA ist eine Initiative, die sich dafür einsetzt, die Art und Weise, wie wissenschaftliche Forschung bewertet wird, zu verbessern. Sie bietet eine Reihe von Empfehlungen zur Verwendung alternativer Metriken und zur Reduzierung der Abhängigkeit vom Impact Factor.

- Leiden Manifesto for Research Metrics:

http://www.leidenmanifesto.org/

Das Leiden Manifesto präsentiert zehn Prinzipien für einen verantwortungsvolleren Umgang mit Forschungsmetriken und die Berücksichtigung verschiedener Indikatoren bei der Bewertung von Forschung.

- Altmetric:

https://www.altmetric.com/

Altmetric ist eine Plattform, die alternative Metriken für wissenschaftliche Publikationen anbietet. Sie verfolgt und analysiert Online-Aktivitäten im Zusammenhang mit wissenschaftlichen Artikeln, um deren Einfluss jenseits von Zitierungen zu messen.

- Metrics Toolkit:

https://www.metrics-toolkit.org/

Das Metrics Toolkit ist eine Ressource, die Forschenden dabei hilft, verschiedene Forschungsmetriken und -indikatoren zu verstehen und zu nutzen. Es bietet Anleitungen zur Auswahl und Interpretation von Metriken und erläutert deren Stärken und Schwächen.

- «Why the impact factor of journals should not be used for evaluating research»

von Per O. Seglen, BMJ (1997): https://www.ncbi.nlm.nih.gov/pmc/articles/PMC2126010/

Dieser Artikel diskutiert die Probleme und Einschränkungen des Journal Impact Factors und argumentiert, dass er nicht zur Bewertung von Forschung verwendet werden sollte.

Diese Verweise bieten zusätzliche Informationen und verschiedene Perspektiven auf das Thema Journal Ranking, Kritik und alternative Metriken. Sie können den Leser:innen helfen, das Thema weiter zu erkunden und ein tieferes Verständnis für die verschiedenen Aspekte der Debatte zu entwickeln.